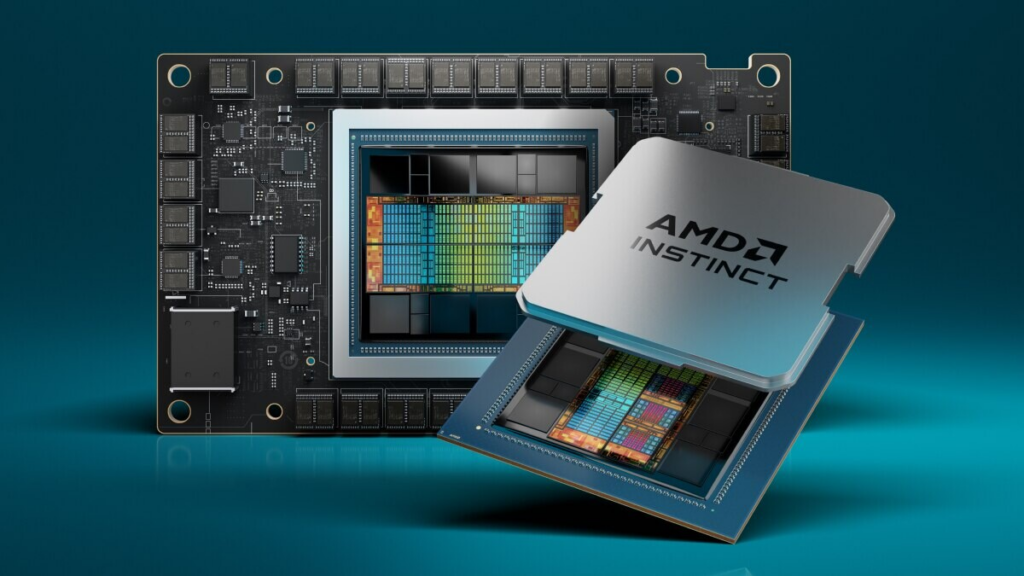

Сегодня компания AMD объявила о доступности ускорителей AMD Instinct MI300X — с лучшей в отрасли пропускной способностью памяти для генеративного искусственного интеллекта и лидерской производительностью для обучения и вывода моделей больших языков (LLM), а также ускоренного процессора AMD Instinct MI300A (APU), объединяющего новейшая архитектура AMD CDNA 3 и процессоры Zen 4 обеспечивают революционную производительность для рабочих нагрузок высокопроизводительных вычислений и искусственного интеллекта.

«Ускорители AMD Instinct серии MI300 разработаны с использованием наших самых передовых технологий, обеспечивают лидирующую производительность и будут использоваться в крупномасштабных облачных и корпоративных развертываниях», — сказал Виктор Пэн, президент AMD. «Используя наше передовое оборудование, программное обеспечение и подход открытой экосистемы, поставщики облачных услуг, OEM- и ODM-производители выводят на рынок технологии, которые позволяют предприятиям принимать и развертывать решения на базе искусственного интеллекта».

В число клиентов, использующих новейший портфель ускорителей AMD Instinct, входит Microsoft, которая недавно анонсировала новую серию виртуальных машин (VM) Azure ND MI300x v5, оптимизированных для рабочих нагрузок искусственного интеллекта и работающих на ускорителях AMD Instinct MI300X. Кроме того, ожидается, что El Capitan — суперкомпьютер на базе APU AMD Instinct MI300A, расположенный в Ливерморской национальной лаборатории Лоуренса, станет вторым суперкомпьютером экзафлопсного класса на базе процессоров AMD и, как ожидается, при полном развертывании будет обеспечивать более двух экзафлопс производительности двойной точности. Oracle Cloud Infrastructure планирует добавить физические экземпляры на базе AMD Instinct MI300X к высокопроизводительным ускоренным вычислительным экземплярам компании для искусственного интеллекта. Планируется, что экземпляры на базе MI300X будут поддерживать OCI Supercluster со сверхбыстрой сетью RDMA.

Несколько крупных OEM-производителей также продемонстрировали ускоренные вычислительные системы одновременно с мероприятием AMD Advancing AI. Dell продемонстрировала сервер Dell PowerEdge XE9680 с восемью ускорителями AMD Instinct серии MI300 и новым проверенным дизайном Dell для генеративного искусственного интеллекта с платформами искусственного интеллекта на базе AMD ROCm. HPE недавно анонсировала HPE Cray Supercomputing EX255a, первый суперкомпьютерный ускоритель на базе гибридных процессоров AMD Instinct MI300A, который станет доступен в начале 2024 года. Lenovo объявила о своей проектной поддержке новых ускорителей серии AMD Instinct MI300, доступность которых запланирована на первую половину года. 2024. Supermicro анонсировала новые дополнения к своему поколению ускоренных серверов H13 на базе процессоров AMD EPYC 4-го поколения и ускорителей AMD Instinct серии MI300.

AMD Instinct MI300X

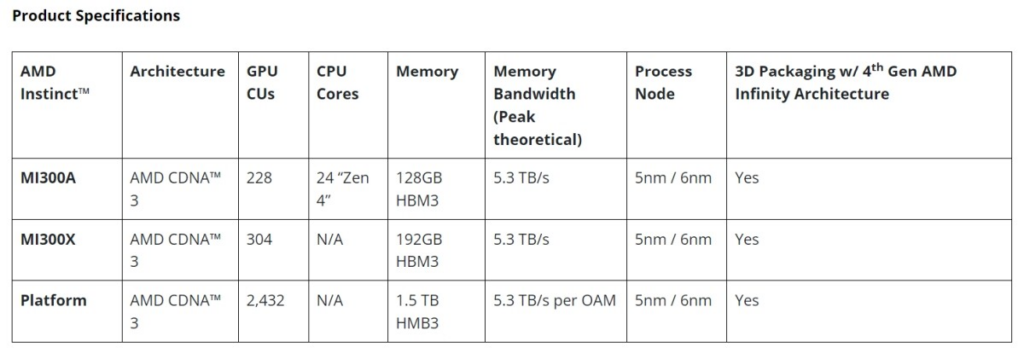

Ускорители AMD Instinct MI300X основаны на новой архитектуре AMD CDNA 3. По сравнению с ускорителями AMD Instinct MI250X предыдущего поколения, MI300X обеспечивает почти на 40% больше вычислительных блоков, в 1,5 раза больше объема памяти, в 1,7 раза большую пиковую теоретическую пропускную способность памяти, а также поддерживает новые математические форматы, такие как FP8 и разреженность; все они ориентированы на рабочие нагрузки искусственного интеллекта и высокопроизводительных вычислений.

Сегодняшние LLM продолжают увеличиваться в размерах и сложности, требуя огромных объемов памяти и вычислительных ресурсов. Ускорители AMD Instinct MI300X оснащены лучшей в своем классе памятью HBM3 емкостью 192 ГБ, а также пиковой пропускной способностью памяти 5,3 ТБ/с, что обеспечивает производительность, необходимую для все более требовательных рабочих нагрузок искусственного интеллекта. Платформа AMD Instinct — это передовая генерирующая платформа искусственного интеллекта, построенная на основе стандартной отраслевой конструкции OCP с восемью ускорителями MI300X и предлагающая лучший в отрасли объем памяти HBM3 объемом 1,5 ТБ. Стандартная конструкция платформы AMD Instinct позволяет OEM-партнерам интегрировать ускорители MI300X в существующие предложения искусственного интеллекта, а также упрощать развертывание и ускорять внедрение серверов на базе ускорителей AMD Instinct.

По сравнению с NVIDIA H100 HGX, платформа AMD Instinct может обеспечить увеличение пропускной способности до 1,6 раз при выполнении вывода на LLM, таких как BLOOM 176B, и является единственным вариантом на рынке, способным выполнять вывод для модели с параметрами 70B, такой как Llama2. на одном ускорителе MI300X; упрощение развертывания LLM корпоративного класса и обеспечение превосходной совокупной стоимости владения.

AMD Instinct MI300A

APU AMD Instinct MI300A, первые в мире APU для центров обработки данных для высокопроизводительных вычислений и искусственного интеллекта, используют 3D-упаковку и архитектуру AMD Infinity четвертого поколения для обеспечения лидерской производительности при критически важных рабочих нагрузках на основе конвергенции HPC и искусственного интеллекта. Гибридные процессоры MI300A сочетают в себе высокопроизводительные ядра графического процессора AMD CDNA 3, новейшие процессорные ядра AMD «Zen 4» x86 и 128 ГБ памяти HBM3 нового поколения, что обеспечивает примерно 1,9-кратное увеличение производительности на ватт по сравнению с FP32 HPC и искусственным интеллектом. рабочих нагрузок по сравнению с AMD Instinct MI250X предыдущего поколения.

Энергоэффективность имеет первостепенное значение для сообществ высокопроизводительных вычислений и искусственного интеллекта, однако эти рабочие нагрузки чрезвычайно требовательны к данным и ресурсам. Гибридные процессоры AMD Instinct MI300A выигрывают от интеграции ядер ЦП и графического процессора в одном корпусе, обеспечивая высокоэффективную платформу, а также обеспечивая вычислительную производительность для ускорения обучения новейших моделей искусственного интеллекта. AMD задает темп инноваций в области энергоэффективности, ставя перед собой цель компании 30×25, направленную на 30-кратное повышение энергоэффективности серверных процессоров и ускорителей для обучения искусственному интеллекту и высокопроизводительных вычислений в 2020-2025 годах.

Преимущество APU означает, что APU AMD Instinct MI300A обладают унифицированными ресурсами памяти и кэша, предоставляя клиентам легко программируемую платформу графического процессора, высокопроизводительные вычисления, быстрое обучение искусственного интеллекта и впечатляющую энергоэффективность для обеспечения самых требовательных рабочих нагрузок HPC и искусственного интеллекта.

Партнеры по программному обеспечению и экосистеме ROCm

Компания AMD объявила о выпуске новейшей открытой программной платформы AMD ROCm 6, а также о своем намерении предоставлять новейшие библиотеки сообществу разработчиков программного обеспечения с открытым исходным кодом, что способствует развитию видения компании в области разработки программного обеспечения для искусственного интеллекта с открытым исходным кодом. Программное обеспечение ROCm 6 представляет собой значительный шаг вперед для программных инструментов AMD, увеличивая производительность ускорения искусственного интеллекта примерно в 8 раз при работе на ускорителях серии MI300 в генерации текста Llama 2 по сравнению с аппаратным и программным обеспечением предыдущего поколения. Кроме того, в ROCm 6 добавлена поддержка нескольких новых ключевых функций генеративного искусственного интеллекта, включая FlashAttention, HIPGraph и vLLM, среди прочих. Таким образом, AMD имеет уникальную возможность использовать наиболее широко используемые модели, алгоритмы и платформы программного обеспечения для искусственного интеллекта с открытым исходным кодом, такие как Hugging Face, PyTorch, TensorFlow и другие, стимулируя инновации, упрощая развертывание решений AMD для искусственного интеллекта и раскрывая истинный потенциал. генеративного ИИ.

AMD также продолжает инвестировать в возможности программного обеспечения за счет приобретений Nod.AI и Mipsology, а также через стратегические экосистемные партнерства, такие как Lamini (работает программы LLM для корпоративных клиентов) и MosaicML (используя AMD ROCm для обеспечения обучения LLM на ускорителях AMD Instinct с нулевыми затратами). изменения кода.

Похожие новости из раздела:

- AMD демонстрирует растущий темп развития решений искусственного интеллекта на базе AMD — от центров обработки данных до ПК.

- AMD представляет революционные инновации для центров обработки данных с расширенной линейкой продуктов

- AMD Instinct MI200 выйдет в этом году

- AMD не смогла выпустить ускорители ИИ для рынка Китая из-за санкций против Китая.